|

|

【ブラウザはGoogle Chrome】

●最新版ダウンロードはこちら 【お知らせ】Windows7でChromeがフリーズを起こす場合は、コントロールパネル⇒管理ツール⇒サービス でWindows Media Player Network Sharing Serviceを停止かつ無効にします。Micorosoftのバグです。 |

||

当サイトはSPAM対策等のためJavaScriptを使っています。

JavaScriptの実行を可能な状態にしてご利用下さい。

Please enable the execution of JavaScript!

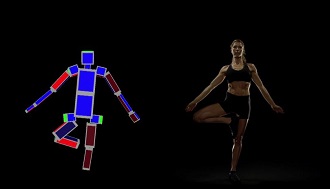

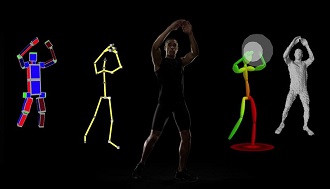

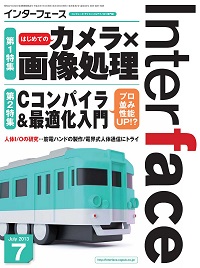

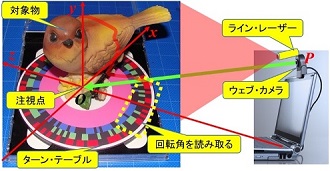

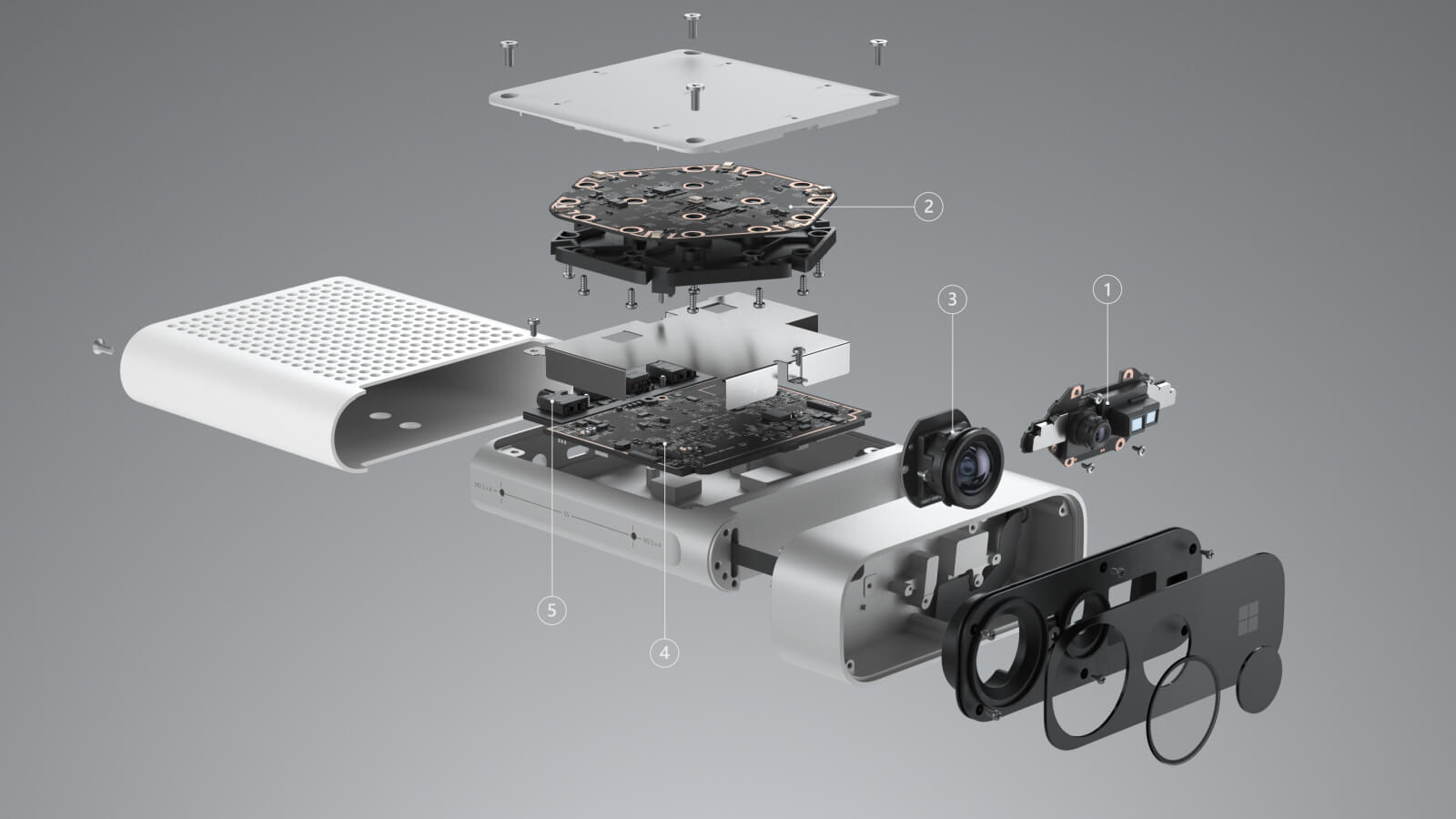

【Kinectが変えるセンシングの世界】~トランジスタ技術【増刊】『今すぐ使える パソコン計測USBマイコン基板』の付録で作る~ |

||

|

【リンクフリー】 私設研究所ネオテックラボ Neo-Tech-Lab.jp 【記載者】 【私設研究所Neo-Tech-Lab】 上田 智章 |

作成日 2012/06/09 更新 2012/06/09 更新 2012/07/07 最終更新 2013/01/14 |

ここにチェックボックス型外部コンテンツ・メニューが入ります。 | ||

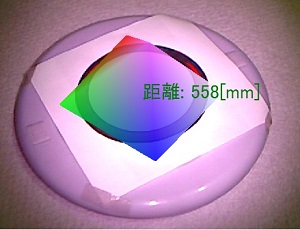

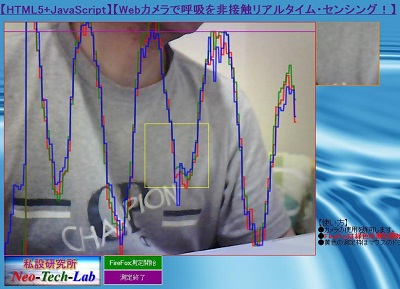

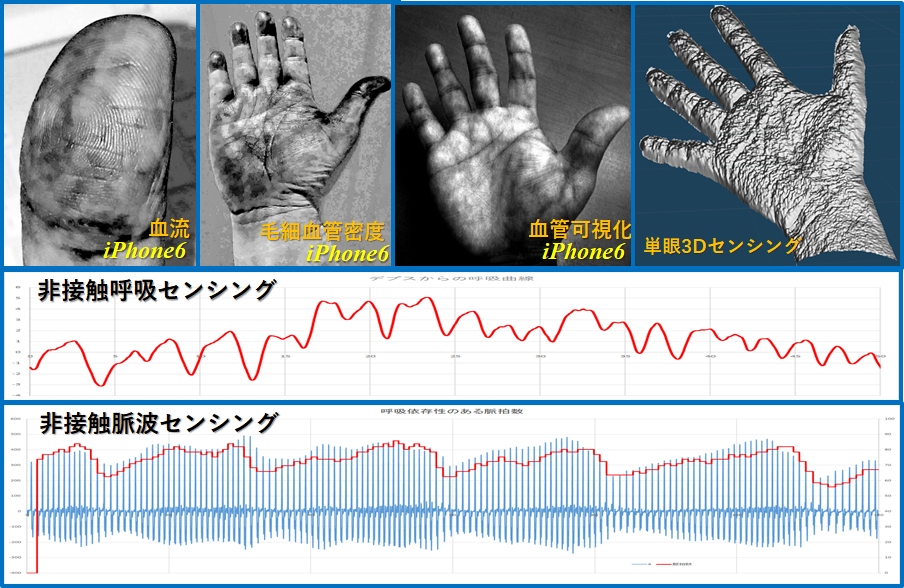

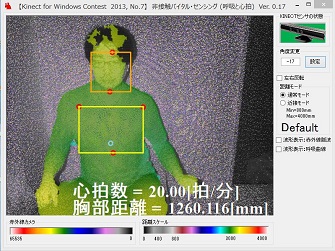

顔・胸部追尾

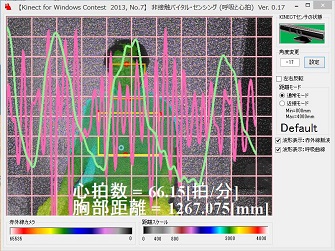

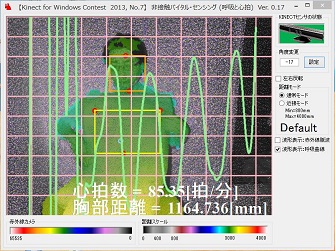

顔・胸部追尾 測定中

測定中 分厚い布団の上からでも体に密着させれば呼吸センシング可能

分厚い布団の上からでも体に密着させれば呼吸センシング可能