|

|

|

||

当サイトはSPAM対策等のためJavaScriptを使っています。

JavaScriptの実行を可能な状態にしてご利用下さい。

Please enable the execution of JavaScript!

【Vocaloid初音ミクとMikuMikuDanceという驚愕のソフトウェア】 |

||

|

【リンクフリー】 私設研究所ネオテックラボ Neo-Tech-Lab.co.uk 【記載者】 上田智章 ☆Tomoaki Ueda☆ NTLMMD |

|

|

ここにチェックボックス型外部コンテンツ・メニューが入ります。 | ||

|

|

|

||

|

【メニュー】 PMDファイルの構造に関する記述や、Excel VBAでPMDモデルを3次元表示するあふぉな試みなど。 【Excel VBA編】【ソース公開中】 ●ポリゴン・フィルとテクスチャー・マッピング ●透視変換 ●光源計算 【NyARToolkitCSで拡張現実編】【ソース公開中】 ●【ポリゴン、テクスチャーマッピング、Sphere Mapping編】 ●【表情処理編】 【拡張現実センサ編】 ●AR sensor(拡張現実センサ) 【予想】●IK bone制御[ただのメモだよ] 【過去記事メニューへ】 【期間】2008/03/11~ 【English page】 |

■■■記載日2014年05月09日■■■22:59頃記載【MMD on WebGL】現時点で、edvakf氏のMMD on WebGLがHTML5+JavaScript(WebGL)で3次元モデル表示をモーション付きで実装されている最も優れたコードだと思います。PMD形式のモデルファイルとVMD形式のモーションファイルをバイナリで読み込み実行することができます。使い方も簡単です。1) MMDデモ1(背景の手前に表示) 2) MMDデモ2(Webカメラを同時に使う場合) 3) MMDデモ3(YouTube動画の上に表示する場合) 4) MMD.jsのソース(若干コメントを付与したもの。)

|

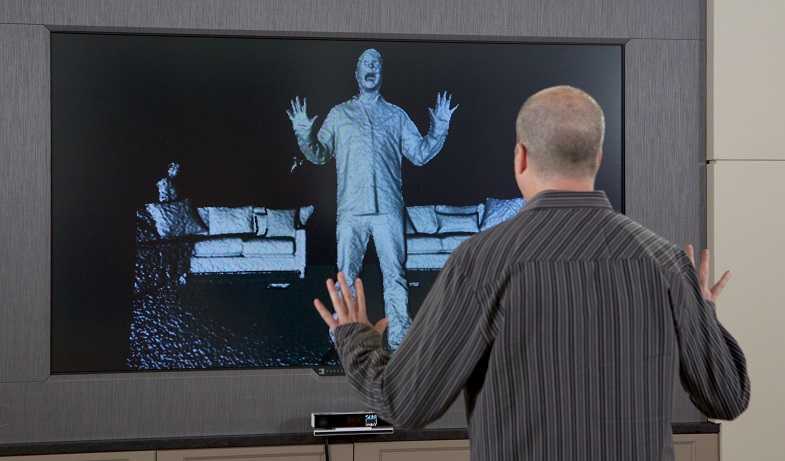

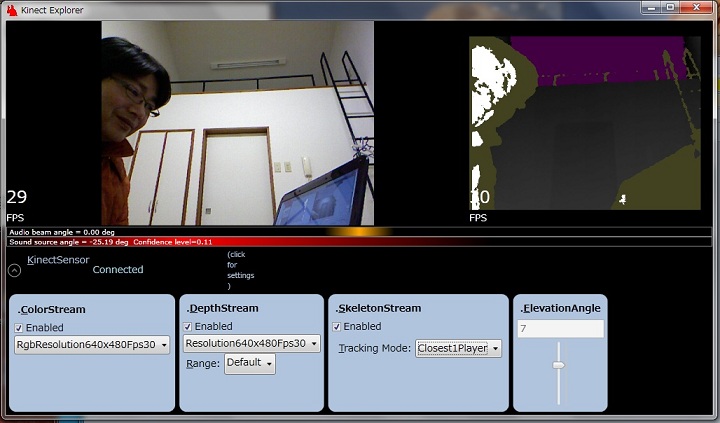

■■■記載日2014年05月04日■■■22:59頃記載【edvakf氏のMMD on WebGL】edvakf氏のMMD on WebGLとKinect for Windows, WebCamをHTML5+JavaScript(WebGL)で同時に使用することが処理負荷的に可能か否かをテストしてみました。デプスイメージのサイズは320×240でテストしました。 KinectはC#のプログラム内にWebSocketのサーバーを組み込んで、ブラウザにデプスイメージをリアルタイムにバイナリ転送しています。WebGLのサポート対象であるGPUが搭載された機種ではそれなりに共存できる段階に来ているようです。骨格トラッキングデータのリアルタイム転送なら全く問題なさそうです。 |

【次世代Kinect】512×424画素の場合【Disclaimer】“This is preliminary software and/or hardware and APIs are preliminary and subject to change.”【免責事項】『次世代Kinect for Windowsのソフトウェアまたはハードウェア及びその両方は暫定仕様であり、APIに関しても暫定的なものであり、変更されることがあります。』 |

【現行Kinect】320×240画素の場合【WebSocketについて】WebSocketサーバーを介して、クライアントプログラム間でテキストやバイナリデータを双方向リアルタイムに転送する技術です。HTML5+JavaScriptもWebSocketに対応したブラウザが出そろってきたので、C#等で作製したKinectのプログラムから、ブラウザ側にデータを転送する事も簡単に実現できるようになりました。 WebSocketサーバーもクライアントも非常に短い処理で記述することができます。サンプルソースを以下に公開します。 Kinect&WebSocketの基本プログラムソースはこちら |

|

|

■■■記載日2014年01月29日■■■22:14頃記載 MikuMikuDance Ver.8.06がアップされているのですが、少し前までwin8.1ではエラーが発生していました。 現在は正常に戻っているようです。 MikuMikuDanceの方は全く何もせずにエラーが出なくなったので、OSの更新に関係があったようです。 |

||

■■■記載日2013年07月18日■■■20:57頃記載【初音ミクのミクミクメイクミク】初音ミクのミクミクメイクミクと言う番組が8月2日から始まるそうだ。ミクミクメイクミク式モデルの公開もあるそうなので、憶えておこう。 サイトURL: フリー素材ダウンロードURL: ●ひかりTV式ミク ver 1.00ZIP型式/7.69MB ●ひかりTV式ミク ねぎジェット ver 1.00ZIP型式/718KB ●ひかりTV式ミク 楽屋 ver 1.00ZIP型式/7.16MB ●ひかりTV式ミク 走るモーション ver 1.00ZIP型式/6.06MB |

【3939make39.tvにアクセスできません】 |

|

|

■■■記載日2013年06月15日■■■17:39頃記載 Perfumeの3次元CGデータが公開された。ダウンロード後に zipファイルを解凍すると、Obj形式のデータがもらえる。 Metaseq Liteで読み込んで、Direct3D形式で保存すればテキスト形式のデータが取得できる。 3人ともtex.pngを前面に張り付けたモデルになっている。 WebGLで表示してみました。 ●【Perfume】『メンバー全員』【WebGL】 |

【Perfumeの3次元CGデータダウンロードサイト】 全部表示し終わるまで待てばダウンロード可能になります。 |

|

|

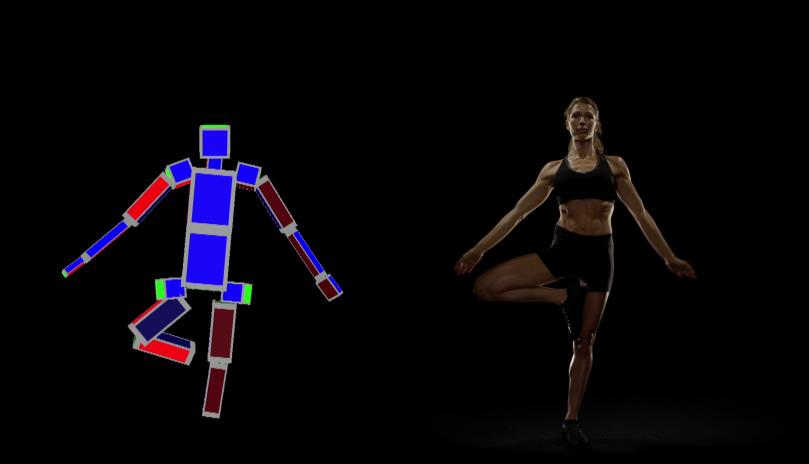

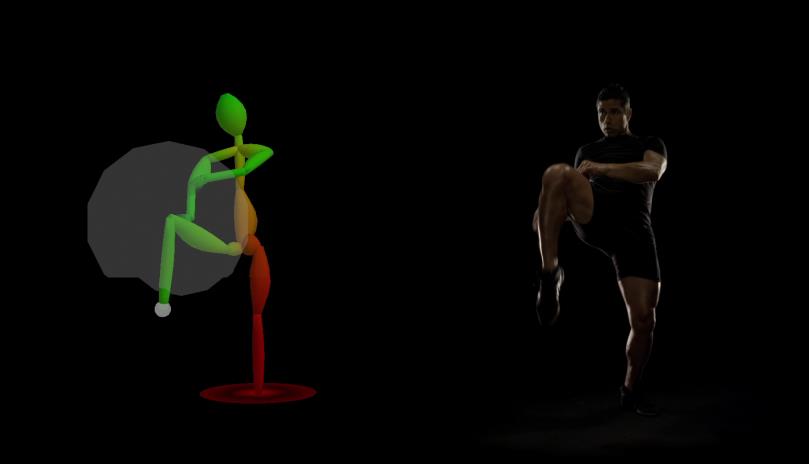

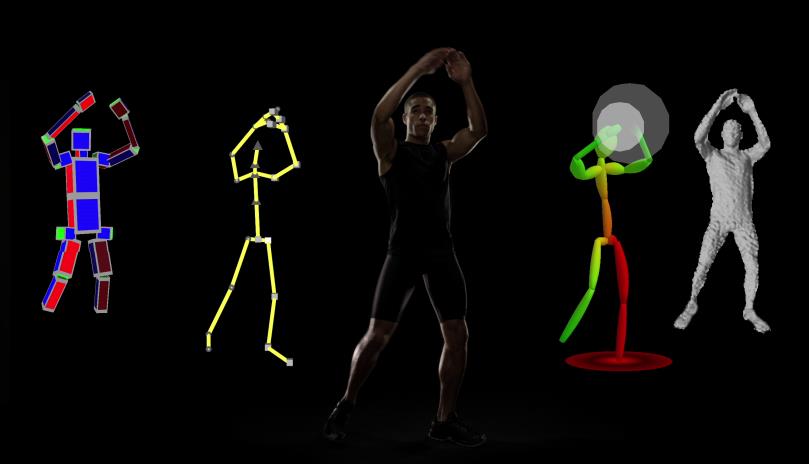

■■■記載日2013年06月02日■■■18:30頃記載 2013年5月22日に米国ワシントン州レドモンドでMicrosoft社がPress Conferenceを開催し、年末にXBOX Oneを発売することと、同梱されるKinect2.0の新機能などを公開した。右のWIREDのYouTube動画にはKinect2.0の新機能が詳しく紹介されている。デプスカメラはTOF(Time Of Flight)方式に変更になった。これは光の飛行時間を変調波の位相遅れという形で検出する方法だ。対応する特許はUS20110188028で詳しく説明されている。これによって距離によらず精確な測距が可能となったため、骨格追尾(Skeletal Tracking)の精度が向上し、親指とそれ以外の指の追尾も可能になった。Grab/Pan(グー/パー)の認識が可能になったわけだ。 加えて、Orientationモードが追加された。これはボーン・ベクトルと回転がキャプチャできる。つまり、ポーズを折れ線近似でキャプチャーするのではなく、顔や体の向きまでもキャプチャーできるようになったのだ。 それだけではない。Muscle+Forceモードという『ドラゴンボール』に登場する『スカウター』のようなモードもある。フレーム間の観測から各部の速度、加速度を検出し、物理エンジンと組み合わせて、重力の影響も考慮して、筋肉にかかる力の可視化が行えるようになり、キックやパンチの力までわかるようになったようなのだ。 さらに、Expressionモードという表情判断機能があり、右眼・左目・口の開閉状態、会話中か否か、メガネの有無、何かを注視しているか、表情は喜怒哀楽のいずれかなどもわかるようだ。 うまくこの情報をVMDに反映できれば、MikuMikuDanceのエディット作業は随分楽になるだろう。 |

【ベールを脱いだKinect2.0の仕様】 2014年にPC接続用Kinect2.0も発売される予定だ。 |

|

【XBOX WIRE Media Assetsからの抜粋】Microsoft社のXbox Wire Media Assets内の『Kinect Video_Tech_ProRes_0517』という動画(.MOV)がお勧めです。

|

|

■■■記載日2013年04月06日■■■17:50頃記載 【ボカロ歌謡祭2013(春)】『~初音ミクから生まれた新たな音楽の世界~<SAナイト>』 4月6日(土)26:10~27:10 ってことは今晩深夜から? キャスト 初音ミク IA GUMI 神威がくぽ ギルティハーツ GACKT 他 あの『ルネ』もでるとか。できれば光源計算をしてやってほしい。 |

|

■■■記載日2013年03月14日■■■13:50頃記載 なんか難解そうだが。Vocaloidの世界が広がっていく。 ★【渋谷慶一郎・初音ミク】 オペラ 「THE END」 【VOCALOID OPERA】 |

|

■■■記載日2013年03月13日■■■11:03頃記載 うわっ。面白そう。真似してみようかな。 ★【GIZMODE】『農業用フィルムを使った透過スクリーンが開発される』

|

|

■■■記載日2013年03月12日■■■15:26頃記載 『七葉院まゆせ バーチャル入社式』 『七葉院まゆせ バーチャル入社式①』 『七葉院まゆせ バーチャル入社式②』 うわっ! 凄いなぁ。 このモデルには愛情がこもってる。 イラストの作者が明らかになるらしい。 ★元記事 ★元記事 |

|

■■■記載日2013年03月10日■■■15:26頃記載 昨日は昼過ぎ頃からサイト閲覧者が潮が引くようにいなくなったので、 『どうして?』と思ったら39の日だったんですね。ミクパをやっていました。 MikuMikuDance登場から5年経ったと言う事ですね。 今回はプロジェクタ2台でスクリーン後方の斜め上から投影されていたので、 プロジェクタの光があまり眩しくなく目立たないように工夫してありましたね。 モーションがモデルの頭身数にぴったりと合っていて、すごく滑らかでした。 ところで、ドラムソロから歌いだす場合のコンピュータとの同期はどうやっているんでしょうか? あれは不思議でなりません。 ところで、以前からの懸案だったBGM Player上にWebGL表示を行う方法について、 FragmentとVertexのShaderスクリプトもPMDに同梱する方法を思いついたので漸く実現しました。 ちょっと読込時間がかかりますが、以前のbmp形式データ・コンテナ方式より倍速にできました。 JSONの仕組みを利用しています。スクリプトを文字列で1行単位に読み込んで改行コードをくっつけてコンパイルしています。 なんでこの方法を思いつかなかったんだろう。今までの方法だと各HTML上に書かなければならなかったので どうしてもプログラムとポリゴンデータが分離していましたが、 この方法だとPolygon Model Dataではなく、Polygon Model Programと言えるのでオリジナルのモデルデータを公開する場合には 著作権法上の保護対象になると思います。Scriptはそのモデルを表示するためのプログラムだからです。 何枚かテクスチャがある場合もなんとか対処できそうです。取り敢えず、ちびミクを表示してみました。 次はBoneを入れて表情も含めVMDで動かさないとね。 昨年は音声データもモデルデザインも着手しながら、才能がないので殆ど進みませんでしたがまだあきらめてはいません。 トライは続けるつもりです。

|

|

■■■記載日2012年11月23日■■■15:49頃記載 【冨田勲「イーハトーヴ交響曲」世界初演 生中継! feat.初音ミク】  【冨田勲「イーハトーヴ交響曲」世界初演 生中継! feat.初音ミク】

【冨田勲「イーハトーヴ交響曲」世界初演 生中継! feat.初音ミク】これTda式? 音楽としてはかなり無理あり。クラッシックには合わないよね。(これは個人的趣向の問題だが。) まあでも実演にはいろいろな困難が伴う中、良くやってると思う。 ストリーミング中継キャパオーバーらしく、1万人越えたら飛んじゃったよ? 概ね10518人再生。 アンコール曲は『リボンの騎士』 短いコンサートだったなぁ。曲数があまりにも少ない。 ミクが出るたびに頻繁にフリーズ。コメに外国語も目立った。国際的。 透明スクリーンに投影するプロジェクタの輝度は大幅に足らないみたい。 機材のレンタル費用の関係かな? 3D映像にキレがない。(平面的で立体感が殆ど無い。) ところで透過性透明スクリーンからそろそろ再帰性反射スクリーンを使った疑似3Dホログラム投影が主流になるような予感がある。 Perfumeライブ【YouTube動画】の事例がそれではないかと思うのだが。 開始後3分間はスクリーン投影。ちなみに本物が登場するまで少し暗いなと思ったが気が付きませんでした。 【参考文献】●共同印刷『再帰性反射シール』ミクロンサイズのガラスビーズを使った再帰性反射。既に交通標識ではポピュラー。耐久性に優れ、普段下地が見えるのが特徴。 ●NTT『ホログラム反射スクリーン』(レンチキュラーの反射バージョン) これは昔からお菓子の景品なんかについていた立体シールの投影反射スクリーン版。アクリルなんかに溝を掘ればすぐ作れる。 スクリーンが埃で汚れやすいかも。 ●『ホログラム反射スクリーン』 【Perfume ホログラム投影&モーションキャプチャー実演ライブ】【BGM停止ボタン】⇒●開始後、3分間はホログラム投影映像。1:20にPerfumeが登場するも足元が透けている。 なんだか暗いし、少しボケているような....と思ったら3人はホログラム映像だった。3:00で本物が登場して判明。 人物の手前にCGが表示される場合もあるので、透明スクリーンが観客とPerfumeの間にあるのだろう。 明らかに前方からの投影だ。10:00までがデモ。 でも動作原理がさっぱり。一昔前なら魔術ですよ。ボケ頭で考えついたのは上記3特許文献の技術のみ。 ホログラフィック投影ライブは日本初とのこと。今後は遠距離高輝度高精細プロジェクタがカギだと思う。 今後、高輝度化、高分解能化、高精度3Dシェープトラッキング&リアルタイム3D上書きが実現したら、 衣装/コスプレのリアルタイム・チェンジも夢ではなくなる。すっかりアニメの世界が現実味を帯びてきたようだ。 昔話でなんだが、20年前は500MFlopsはスパコンの世界だったが、今ではCORE i3 2.26MHzで28GFlopsとか。 既にXBOX360は2年前にシステム性能1TFlopsを実現している。 10年もしないうちにパソコン性能は1京Flops(=10ペタFlops=10000TFlops=10000000GFlops)を超えているだろう。 有り余るCPUパワーがあれば簡単だろう。 だけど、そのうちプロポーション変更とかやりだしそうなのも心配だ。 スクリーンの要らないホログラム表示技術の開発も急務かな。 ミクロンサイズビーズの多方位独立自己発光デバイスが実現可能なら、スプレーで吹き付けるだけでOK。 整形手術や化粧も衣装も必要なくなり、『裸の王様』の世界が実現しているかもね。 可視光線域では衣装を着ているように見えても赤外線や紫外線域では...... この場合、人類みな《裸の王様》状態なわけだが....(^_^;) |

|

■■■記載日2012年10月14日■■■00:15頃記載 【Kinectとセンサの融合で音の拡張現実】 ★2012年8月1日のトラ技オフ会でお話していたKinectドラムシステムを試作し、改良を重ね、 CEATEC2012(幕張メッセ 10/02~10/06)でRohm様ブースにてデモを行いました。 現在のKinect for WindowsやWindows7の性能ではCORE i7でも加速度センサの助けが必要ではありますが、 下のYouTube動画のような演奏が行えるようになりました。 これで楽器がなくても身近なものを何でも楽器化することができるようになりました。 初心者向けに基本コードのアルペジオ奏法とか自動で演奏できるKinectギターとか、 応用の可能性は広がります。 【CEATEC2012 Rohmブース実演デモ】『Augmented Reality Virtual Music System』【Kinectを用いた音の拡張現実】 ≪なんでも身近な物を楽器にしてしまう拡張現実楽器システム≫ ●場所 Ceatec2012 2012年10月2日~6日 ●音の種類判別は、ソフトウェア初期化時にKinectのデプスイメージを8回取得してZ値テンプレートとし、 テンプレートから1cm~15cmの範囲に手が入った場合に、所定の音(オルガン調あるいはドラムや動物の鳴き声)が選択されたものとしている。 ●デプス・イメージ上に見える白い枠線内のデプス値が所定内(1cm~15cm)の変化をしたときにその音源が選択中であると判定している。 なので、なんでも手近なものを楽器化することができる。 デモでは、タジン鍋、皿、おたま、カップ、フライパンなどキッチンスペースにある物を楽器化している。 ●音出しタイミングはKinect単体では実質的に毎秒25フレーム程度なので弾きづらく、両手首の加速度センサが必要となる。 Kionix(Rohmの子会社)製のI2CインターフェースKXTI9-1001をUSBシリアルコンバータ(FT232R)をBitBangモードで接続。 但し、エレクトーン経験の豊富なコンパニオンさんが弾いているので、デモのように何とか演奏で来ているが、 今後、より一層の改良を繰り返さないとまだまだライブ演奏には使えるレベルではないかも。 ●デモではお玉やコップ付近は間隔が接近し過ぎて弾きづらい原因になっている。 ●当初、ドラム・システムでのデモを考えたが、ドラム・ソロは演奏者が限定されてしまうので、エレクトーン風味に変更。 音源(wavファイル)はExcel VBAでDDS(Direct Digital Synthesizer)アルゴリズムで作製。 ●プログラムはKinect for Windows SDK Version 1.5を使い、Visual C#で記述。 ●同時に複数音を再生させるために、DirectX.AudioVideoPlaybackを利用。 【Kinect】『Augmented Reality Virtual Drums System』【試作版】≪我が家でドラム演奏を楽しめる≫ ●2012年8月1日のトラ技オフ会でお話していた拡張現実ドラムシステムの試作段階の物。スタンダードドラムセット。 同時に複数の音が出るようにDirectX.AudioVideoPlaybackを使用。 スクリーン・キャプチャとサウンド・レコーダーの音ズレすみません。 ●ドラム演奏は両手、右足に加速度センサ、左足にフットスイッチを使う。 両手にはヒッコリー材のスティックを持って演奏できる。 右足はバスドラム。左足はハイハット・ペダルで、オープン・ハイハットとクローズド・ハイハットの切り替えに使う。 |

|

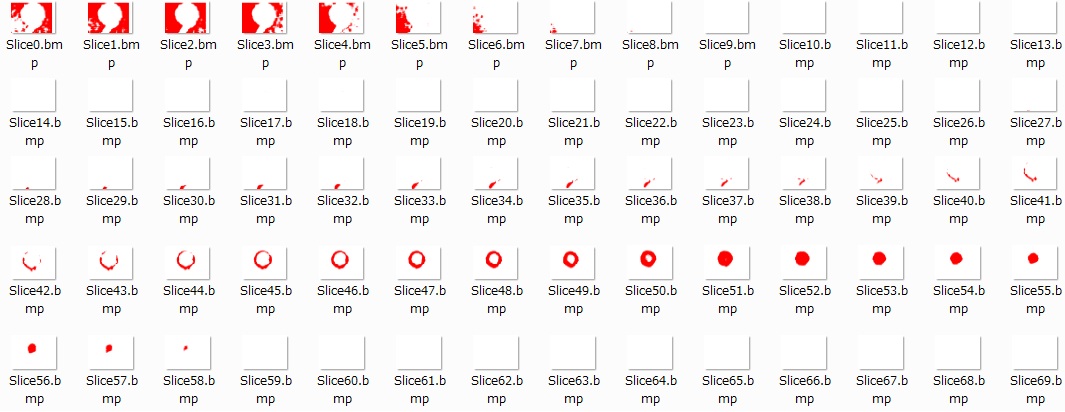

■■■記載日2012年04月14日■■■15:26頃記載 【Kinectセンサのデプスカメラを自作中】(その2) PC用プロジェクタとウェブカメラで実験を行ってデプスカメラの動作原理を確認することに成功。 実験装置はEPSON製EB-S02(33,000円)とELECOM UCAM-DLY300TA(3,500円)で構成。 装置の物理的サイズの制約でプロジェクタとカメラ間の距離がKinectは7.5cmだが14cmになったので、ちょっと近距離は大変だったが。 実はたまたま30年前からKinectのデプスカメラに関係する技術の研究をしていたようで.... こんな大きなドットで本当にデプスが求まるのだろうかと思ったが、MRI断層撮影装置のように結果がでてびっくり!! 最初に考えた人。凄いよ。『乱数』恐るべし。 Kinectセンサのアルゴリズムは劇的に改善できると思う。少なくとも数十分の1の処理負荷になるはず。 赤外線ランダム・ドット・パターン・プロジェクタとウェブカメラだけなら5,000円くらいになるのではないだろうか? プラネタリウムの作り方とか調べてみようかと思案中。 【Kinectのデプスイメージに近いものです】  【断層撮影装置のようなスライス画像がたった1枚の画像から得られるので不思議!!】

【断層撮影装置のようなスライス画像がたった1枚の画像から得られるので不思議!!】 |

|

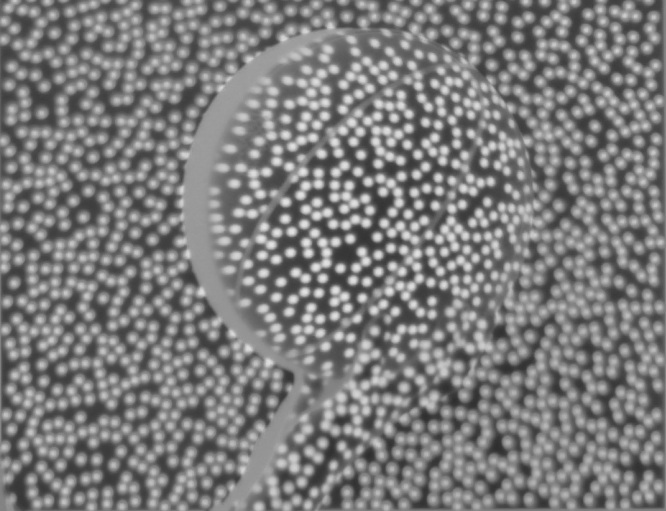

■■■記載日2012年04月11日■■■22:39頃記載 【Kinectセンサのデプスカメラを自作中】 サイボーグインターフェースのひとつ『Cyber Eye』にはデプスカメラが必須なので自作中です。 Kinectセンサよりも性能向上を行うため本当は少し違う方法を試作しています。 以下は比較のためのKinect方式に近い方式のほうの結果です。 漸くランダムドットパターンの抽出に成功しました。 次は深度情報抽出処理に進みます。  【Kinectは赤外線領域ではこんな感じでランダムドットが投影されています】 【赤外線カメラで捕捉するとこんな感じの画像が得られます】 |

|

■■■記載日2012年02月29日■■■22:09頃記載 【Bone】 MMDの物理エンジンBulletでCapsuleShape(カプセル・シェープ)が使われているのを知っていたが、あれの凄さが今一つわかっていなかった。 180°あたりの分割数が奇数で同じなら、CapsuleShapeの長さを0にするとBallShapeになる。頂点数は変わらない。 インデックス・バッファは頂点数が変わらないのでそのままでよく、VertexBufferを少しいじるだけで済んでしまう。 だからCapsuleShapeとBoxShapeだけでモデルを構成すれば最小のメモリ使用で高速に描画が行えるわけだ。 これに加えてBoneの処理も簡単になるようだ。うまくできているなあ。 それと、キネクトで骨格をキャプチャーしたとき個々のボーンの長さがばらつくのだが、MMDはどこでそれを吸収しているのだろうか? 自分でやってみて、モデル側の長さをボーンに合わせたら、なんかダボダボな感じになってしまった。 意外にボーンのつじつま合わせは難しいかも。 (MMDでは、2つの座標変換をミックスする方法をとっている。ミックス比率も場所によって変更している。)   |

|

■■■記載日2012年02月12日■■■01:19頃記載 【画像に含まれる任意の傾斜楕円の高速検出に成功】 これで正方形マーカーより低負荷で円形マーカーの検出が可能になることを確認できた。 むしろ線分の方がはるかに重い。(サンプルプログラムをVisual C#で書いたところ、リアルタイム処理速度を確認。YouTubeに限定公開中。) (動作原理、KINECTサンプルプログラム等の一般公開は都合により7月頃とします。)  |

|

■■■記載日2012年02月10日■■■03:25頃記載 【Microsoft社が正式にKinect for Windows SDK Version1の配布を開始】 2012年2月1日にSDKの正式版が発表されました。 センサ上下角の遠隔操作、音声認識エンジン(Speech)、音源方向の検出、音声データの録音(.wavファイル)も統合されました。 24,800円で予約受付中のPC接続専用Kinect for Windowsでなくても、15,000円のXBOX360用KinectセンサをPCで動作させることができました。 これにより、Start, Stop等の音声でのプログラム制御が可能になります。 β版に比べ、SDKは比較にならない程改善されており、理解しやすい言語仕様になっています。 英文ながら、非常に親切なドキュメントが付属しており、各機能の使い方を丁寧に解説してくれています。 ちょっといじってみたのですが、音声認識エンジンも簡単に使えます。 認識させたい単語をChoiceに登録(add)するだけで、簡単に認識できる制御キーワードを増やすことができます。これは面白いです。  |

|

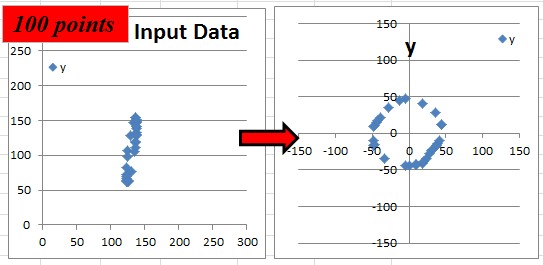

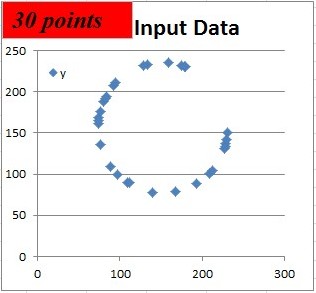

■■■記載日2012年02月10日■■■03:15頃記載 【円や円弧を構成する点集合から円の中心座標を推定する超高速アルゴリズムも解決しました】 IK boneと同じような反復法の一種ですが、円や円弧を構成する30点程度の点列データから超高速で円の中心座標を推定するアルゴリズムも理論通り動作することを確認しました。 Hough変換と異なり、半径を最後に求めるときにしか√の計算の必要がありません。 線分抽出の方がむしろ遅いという事態になり、線分抽出速度の方を改善するべきかも。 PTAM (Parallel Tracking and Mapping)では動画のキャプチャー画像から孤立点を抽出して3次元情報を取り出しますが、 線分や円弧情報から構造データをリアルタイムでTrackingすることも可能になりそうな気がします。   ■■■記載日2012年02月07日■■■03:00頃記載 【ARToolKitのようなマーカー式拡張現実処理をオリジナル方式でコーディング開始(その2)】 Hough変換のところも、オリジナルの高速最小二乗法アルゴリズムを考案しました。 Excel VBAで、画素集合から正しく勾配(Ymajor)を演算できることを確認。 全部オリジナルで書けそうだ。 ■■■記載日2012年02月05日■■■20:25頃記載 【ARToolKitのようなマーカー式拡張現実処理をオリジナル方式でコーディング開始】 Kinectセンサは骨格抽出だけでなく、ウェブカメラとしても使えるので、ARToolKitのようなマーカー式拡張現実も使えたら面白いなと思ったので、 例のごとく、昨日からオリジナル・アルゴリズムでコーディングを開始しました。試行錯誤を重ね、漸く、左下画像からマーカーだけの抽出が行える ところまで来ました。太い黒い線を検出するオリジナル信号処理アルゴリズムを流用。いきなり、マーカー部分だけを抽出することができました。 まだ切り出した画像は少し変形していますがなんとかなりそうです。右下の画像は4頂点のスクリーン座標を抽出するためのものです。 1マーカーだけのARならHough(ハフ)変換無しでもなんとかなりそう。マーカーの四隅の4頂点のスクリーン座標さえ、取り出せれば、あとは テクスチャーマッピングでスクリーン画像からマーカー部分を正方形イメージとして切り出し、90度ずつ回転させて登録マーカー画像とよく一致する 状態にして、逆透視変換マトリックスで3次元座標を得ればいいだけ。 この方法、マーカーの形状は関係ないので、円形マーカーも√なんか使わずにOKになりそうです。   |

|

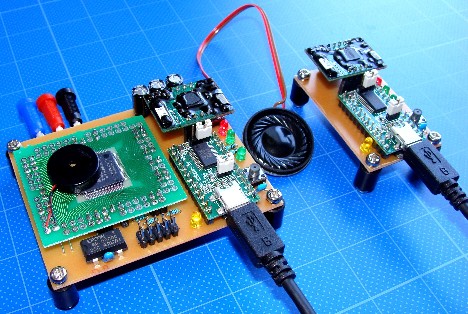

■■■記載日2012年02月03日■■■18:55頃記載 【μ-iVoiceのハードウェア版】 ミク型ターミネータ開発に向けて、人工声帯とするべく、ハードウェアを製作してみました。 本体の頭脳部分は今のパソコン性能では何年か先でしょうけど。 やはり数百台規模の広域分散処理ネットワークでないと無理か。  |

|

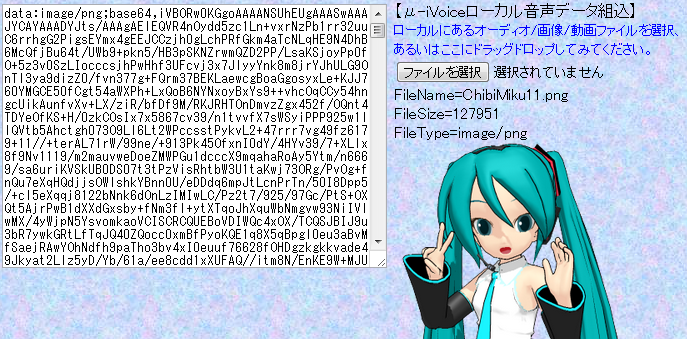

■■■記載日2012年01月15日■■■14:43頃記載 【μ-iVoice Version0.09】 データベースの構築はまだこれからですが、漢字を自動的にひらがなに読み替える機能を付与したμ-iVoice Version0.09を公開しました。 ローカルにある音声データの組み込み機能もVersion0.08で加わっています。 Excel VBAの音声データ録音・編集ツールで任意話者の音声データを作成し、組み込むことができるようになりました。 予備実験で確認した限りでは、将来的には、『あいうえお』の5音を登録するだけで、任意の人の声をものマネできるようになりそうです。 実は母音である『あいうえお』以外の音声は子音と母音で構成されているのですが、子音の部分だけ取り出して聞いても、 広帯域スペクトルを持った過渡的な音声なので、性別はおろか誰の声かもわからないのです。 母音の部分だけを別人の母音で置き換えてみると、そっくりな声に聞こえてしまうから不思議です。 開発中の自動編集ツールで、この辺のブレンドを解決できるのではないかと考えています。 将来的には『あいうえお』の録音だけで、音声置き換えが可能になるだろうと考えています。 置き換えが困難なのは、な行、ま行、ん等です。これを解決できればいいのですが。 Version0.09では漢字データベースを中心に取り組みましたが、 実は、漢字データベースに制御スクリプトを使うこともできるので、将来的にはアクセントも自動変換できるようになっています。 残された課題の中での問題点は、音声データの転送バイト数削減です。圧縮するか、データ構造の見直しを行う必要がありそうです。 この辺りのソフトウェア技術は古くから取り組まれている分野なのですが、私には激しく異分野なので勉強する必要があるのです。  【図】ローカルにある音声データ組み込み機能の一部を使ったデモの例 ローカルにある画像ファイルをドラッグ・ドロップすると...... 漢字辞書をある程度充実させたら、今度はWebGLに戻ってBoneと表情をなんとかしよう。 漸く、Web Agentへの接続が見えてきた気がする。 |

|

■■■記載日2012年01月09日■■■03:12頃記載 【テスト版μ-iVoice】 まだ、いろいろ復旧できていませんが、Ver.0.07β版のμ-iVoiceをアップしてみます。 昨年、ブラウザの改訂で動作しなくなったのはどうやら型付配列(Uint8Array等)のindexOfが1MB以上だと動作しなくなっているからのようです。 セキュリティー対策にしては手抜きなので、ブラウザのバグの可能性が高そうです。 |

|

【μ-iVoice】『JavaScriptだけで音声合成/シンセサイザをサイトに実装するAPI』(第2次試作2011/12/29/~2012/01/09/)μ-iVoiceはプラグインに頼らずにJavaScriptだけでシンセサイザ/音声合成/ボーカロイドをホームページに実装するAPIです。 ハードウェア技術であるDDS(Direct Digital Synthesizer)の変形アルゴリズムで実現しました。Version0.06では、音声データをAI学習させたデータを使用していましたが、Version0.07以降は音声データをブラウザ上で加工する方式に変更しました。今後は音質改善に取り組みます。 現状はひらがな入力のみに対応しています。抑揚を付けるための簡単な制御文字も持っています。自動抑揚変換も開発中です。 対応ブラウザは、Google Chrome、Mozilla Fire Fox、Apple Safariです。IEは.wav形式オーディオファイル再生に対応していないので利用できません。将来的には、ブラウザにNaCl(Native Client)+Pepperが標準実装されるようですから、漢字入力から発音させるまでを全部ブラウザ上で行うことも可能でしょう。テキスト化したMIDIデータから演奏する機能も備えています。近いうちにAltera社のCPLD(MaxII)で音声合成チップを製作する予定です。 ●【web.fc2.com】【μ-iVoice】 ●【geocities.jp】【μ-iVoice】 ●【sites.google.com】【埋め込みμ-iVoice】 |

|

■■■記載日2012年1月7日■■■16:20頃記載 【μ-iVoice Webで使える音声合成API。もうすぐ公開?】 JavaScriptだけで実現する音声合成API μ-iVoiceの開発をしています。 主要ブラウザ側でセキュリティー関連の変更があったらしく、大きな容量のJSONP受け渡しに問題が発生したので、100程ある抜け道から1つを選んでコーディングし直しました。 音声データベース、ドラム音データベース共に、モノラル, 16bit, 22.05kSPSで作成してみました。 次のバージョンでは、音質を向上させるための処理を加える予定です。 Google Text-To-Speechのようにパラメータ付URLで発声したり、ブログなどでも使えるように追加の作業を行っています。 より人間の発音に近い自然な音声合成を行うために下のようなスクリプト型に変更しようとしています。 音の高さをC#4、F5のように指定し、音の長さをL10, L5のように指定、音の強さをV5, V7のように指定するようにします。 次のバージョンでは、こんな感じで入力するようになります。 A4L10V7こB4んにちわ。A4はB4つねみG4くなのA4L14よろしくL20ね。 スクリプトが面倒な人向けにC#版コンポーザも試作開始しました。 【実験サンプル】『なんちゃってミク』声版 (base64形式データコンテナを使った改良版)  図 C#で製作中のイントネーション等を編集できる音声合成コンポーザ |

【過去記事メニュー】 |

||

【↓記事へのリンク】 |

【↓記事題名】 |

|

| ■■■記載日2010年11月19日~2011年12月25日の記事■■■ |

【記載日2010年11月19日~2011年12月25日の記事】 |

|

|

■■■記載日2011年12月25日■■■ ■■■記載日2011年12月07日■■■ ■■■記載日2011年11月09日■■■ ■■■記載日2011年10月06日■■■ ■■■記載日2011年9月12日■■■ ■■■記載日2011年8月12日■■■ ■■■記載日2011年8月9日■■■ ■■■記載日2011年7月31日■■■ ■■■記載日2011年7月30日■■■ ■■■記載日2011年7月16日■■■ ■■■記載日2011年7月7日■■■ ■■■記載日2011年7月2日■■■ ■■■記載日2011年7月2日■■■ ■■■記載日2011年7月1日■■■ ■■■記載日2011年6月27日■■■ ■■■記載日2011年6月13日■■■ ■■■記載日2011年6月10日■■■ ■■■記載日2011年6月10日■■■ ■■■記載日2011年6月4日■■■ ■■■記載日2011年5月24日■■■ ■■■記載日2011年5月9日■■■ ■■■記載日2011年5月8日■■■ |

【またなんかブラウザの仕様が変更になったかも?】 【MMDのダウンロードページにボタンを発見!】 【MMD最新版Version7.39.dotリリース!】 【MMD海外ユーザーにKinect導入者が増え始めた】 【MMD世界傾向】 【Web シンセサイザ/ボーカロイドを一から製作してみた】(第1次試作) 【Web シンセサイザ/ボーカロイドを一から製作してみよう】 【MikuMikuDanceは開発終了?】 【Pocaloid2って何ですか?】 【WebGLでPMDを表示してみた】 【WebGLでちびミクを表示してみた】 【Kinect for Windows SDK Betaをインストールしてみた】 【FireFox5でWebGLを動かそうとすると発生する不具合】 【FireFox5でWebGLを動作させるには?】 【FireFox5.0ではWebGLでCross-DomainイメージをTextureにできなくなった件】 【WebGL / bullet.js のデモを見つけました】 【WebGLに関する解り易いページは?】 【Vocaloid3 Editorが今秋発売予定】 【WebGLが面白そう】 【MikuMikuDanceのモデルデータにPMX仕様が追加された模様】 【OpenNI.Net.dllが仕様変更になった件】 【米ToyotaのCollora CMにMiku登場】 |

|

■■■記載日2011年5月5日■■■ ■■■記載日2011年5月3日■■■ ■■■記載日2011年4月8日■■■ ■■■記載日2011年4月5日■■■ ■■■記載日2011年3月31日■■■ ■■■記載日2011年3月26日■■■ ■■■記載日2011年3月25日■■■ ■■■記載日2011年3月24日■■■ ■■■記載日2011年3月23日■■■ ■■■記載日2011年2月5日■■■ ■■■記載日2011年2月4日■■■ ■■■記載日2011年1月29日■■■ ■■■記載日2011年1月27日■■■ ■■■記載日2011年1月27日■■■ ■■■記載日2011年1月27日■■■ ■■■記載日2011年1月23日■■■ ■■■記載日2011年1月20日■■■ ■■■記載日2010年11月19日■■■ |

【Google翻訳の音声合成の件、記事を分離します】 【Google翻訳の音声合成が凄い件】 【コミPo!がまた進化したらしい】 【KinectのC#による使い方】 【Kinectが反転していた理由】 【Kinectが左右反転している件】 【OpenNIでIR, image共に左右反転している件】 【KinectをC#で使う方法は? その2】 【KinectをC#で使う方法は?】 【MMDのKINECT】その2 【MMDのPMDで拡張現実:Bone制御のテスト】 【MMDのPMDで拡張現実:表情のテスト】 【MMDのKINECT】 【PMDで拡張現実】Sphere Mappingにトライ(続き) 【YouTubeメモ動画】 【PMDで拡張現実】Sphere Mappingにトライ 【PMDで拡張現実】 【コミPo!(その3)】 【NyARToolkitCSで遊んでみました】 |

| ■■■記載日2010年12月10日■■■ |

【コミPo!(その2)】 |

|

| ■■■記載日2010年11月10日■■■ |

【コミPo!って知ってます?】 |

|

| ■■■記載日2010年10月29日■■■ |

【イギリスで初音ミクが人気】 |

|

| ■■■記載日2010年08月04日■■■ |

【PMDデータを再利用されにくくする方法】 |

|

| ■■■記載日2010年07月31日■■■ |

【PMDデータに著作権はあるのか?】 |

|

| ■■■記載日2010年07月22日■■■ |

【Holophonics Augmented Realityに挑戦中】 |

|

| ■■■記載日2010年06月27日■■■ |

【YouTubeで樋口優さんのチャンネル発見!】 |

|

| ■■■記載日2010年06月20日■■■ |

【待望のKumane Mikuの動画が完成したとのこと】 |

|

| ■■■記載日2010年06月15日■■■ |

【Panoramio向け写真閲覧用公開ツール上でMikuMikuDanceの布教活動】 |

|

| ■■■記載日2010年06月13日■■■ |

【MikuMikuDanceに実装された機能に今頃気が付いたよ】 |

|

| ■■■記載日2010年06月08日■■■ |

【やっぱりなかなか速度がでない。ぱらぱらならどうだろうか。】 |

|

| ■■■記載日2010年05月23日■■■ |

【初音ミクが『あかつき』に搭乗。宇宙へ。】 |

|

| ■■■記載日2010年04月16日■■■ |

【Mikuが逆パターン[実写⇒カメラVMD]を発見。それに続いて同パターン先行事例も。】 |

|

| ■■■記載日2010年04月15日■■■ |

【VMDデータってどうなっているんでしょ?】 |

|

| ■■■記載日2010年04月10日■■■ |

【ARToolKitを少しいじってみる(続き2)】 |

|

| ■■■記載日2010年04月09日■■■ |

【ARToolKitを少しいじってみる(続き)】 |

|

| ■■■記載日2010年04月07日■■■ |

【ARToolKitを少しいじってみる】 |

|

| ■■■記載日2010年04月03日■■■ |

【VBAのバグ直しておきました】 |

|

| ■■■記載日2010年04月02日■■■ |

【久しぶりにVBAを触ってみる】 |

|

| ■■■記載日2010年04月01日■■■ | ||

|

■■■記載日2010年04月15日■■■ |

(セルフ・シャドウに関して勘違いに勘違いを重ねたので記事移動してまとめます。) | |

| ■■■記載日2010年03月15日■■■ |

【えぇ?設定ミス?】 |

|

| ■■■記載日2010年03月13日■■■ |

【ちょっと忘れていたけど動画削除対応をMikuに移管する】 |

|

| 【過去記事・メニューの表示】 チェックを入れると2008年3月11日~2010年2月までの記事メニューがプルダウン表示されます。 | ||